(NLP2024) 3日目

Swallow関連発表の「A6:LLMデータ構築」、認知モデリング関連の「D7:心理言語学・認知モデリング」を中心に参加。

コーパス構築はやっぱり大変だなぁ。ichikara-instructionは「LLMのための日本語インストラクションデータ」を人力作成したという話で現時点で約1万件。論文時点ではその半分まで準備できていて、件数変えてどういう寄与が見込めるかを下流タスクとしてRakudaで検証してみてるらしい。

継続事前学習

継続事前学習は(コーパスに依存すると思うけど)、一旦性能低下した後で徐々にかいく付していく傾向がある模様。ヒトが新しい分野について学ぶような状況の学習曲線みたいなものに似てたりするのかな。別発表でもファインチューニングではなく継続事前学習する方が効果高い(ケースがある)という話してたけど、モデルサイズ、コーパス、タスク、学習方法依存で向き不向きありそうなのが嫌だなぁ。学習ステップごとの推移観察してるのはそのあたりの傾向も見たいということだと思うけど、ケーススタディ増やすことで決定的な解が得られるというよりは「ケースに応じた方法」が積み重なるだけになりそうなんだよな。

認知モデリング・セッションは、これまで見知らぬ世界へ誘われてしまった、、、良い意味で驚きの連続です。ベースにある考え方は「ヒトの認知に関わるデータ(というか生理指標データ)をLLMに追加することでより人間らしいモデルを作ろう」という部分なのかな。いや、これ自体も an idea であって共通部分ではないかもしれないけども。

- 例としては BCCWJ-EyeTrack という「文節単位の読み時間、視線や脳波データ」等を収集したデータセットがあり、トークンにこれらの情報付与して学習させる。これを認知デコーダと呼び、この認知デコーダがヒトの代わりにフィードバック(例えばラベル)を生成するという流れらしい。

- 更に別の例としては、同データセットでファインチューニングすることで「任意のタスクにファインチューニング可能なモデル」を作れるとし、実例として「トークンの読み時間」を高い精度で推定できるようになり、より人間らしいモデルを構築できる(どう失敗しやすいかとか分析に使える)、という報告が。

誤解してる部分多々ありそうだけど、整理指標データを追加することで人間らしさを導入しよう(導入することで応用の範囲が広がるぞ)という思いは理解できたし、強く共感させられてしまった。

野菜が欲しくて野菜カレーに野菜追加 pic.twitter.com/UuQHvu0TTu

— Naruaki TOMA 温泉旅行... (@naltoma) March 13, 2024

A6:LLMデータ構築

- A6-1 Swallowコーパス: 日本語大規模ウェブコーパス #Swallow

- mC4はノイジー。

- Common Crawlのデータウンロード => Trafilaturaでテキスト抽出 => 言語判定(2値分類)

- 言語判定はテキスト抽出後が良いが、言語判定処理時間:テキスト抽出時間=5:95。短縮のためlangタグ、titleタグで効率化。

- 重複多い文書除去 by Rae+(2021)

- 有害表現ページ除去 by NG表現を含む割合

- 低品質ページ除去 by ルールベース

- ホスト名(ブラックリスト)に基づくフィルタリング

- 句読点の正規化、フッター除去

- A6-3 ichikara-instruction LLMのための日本語インストラクションデータの作成

- LLMのための日本語インストラクションデータ作成プロジェクト

- 今後の方向性

- 安全性、マルチターン、マルチモーダル、(分野依存も?)

- 共同研究企業からの声

- データ仕様書作れない

- 事業部の漠然とした要求やシステム要件から何にどう手を付ければいいか分からない

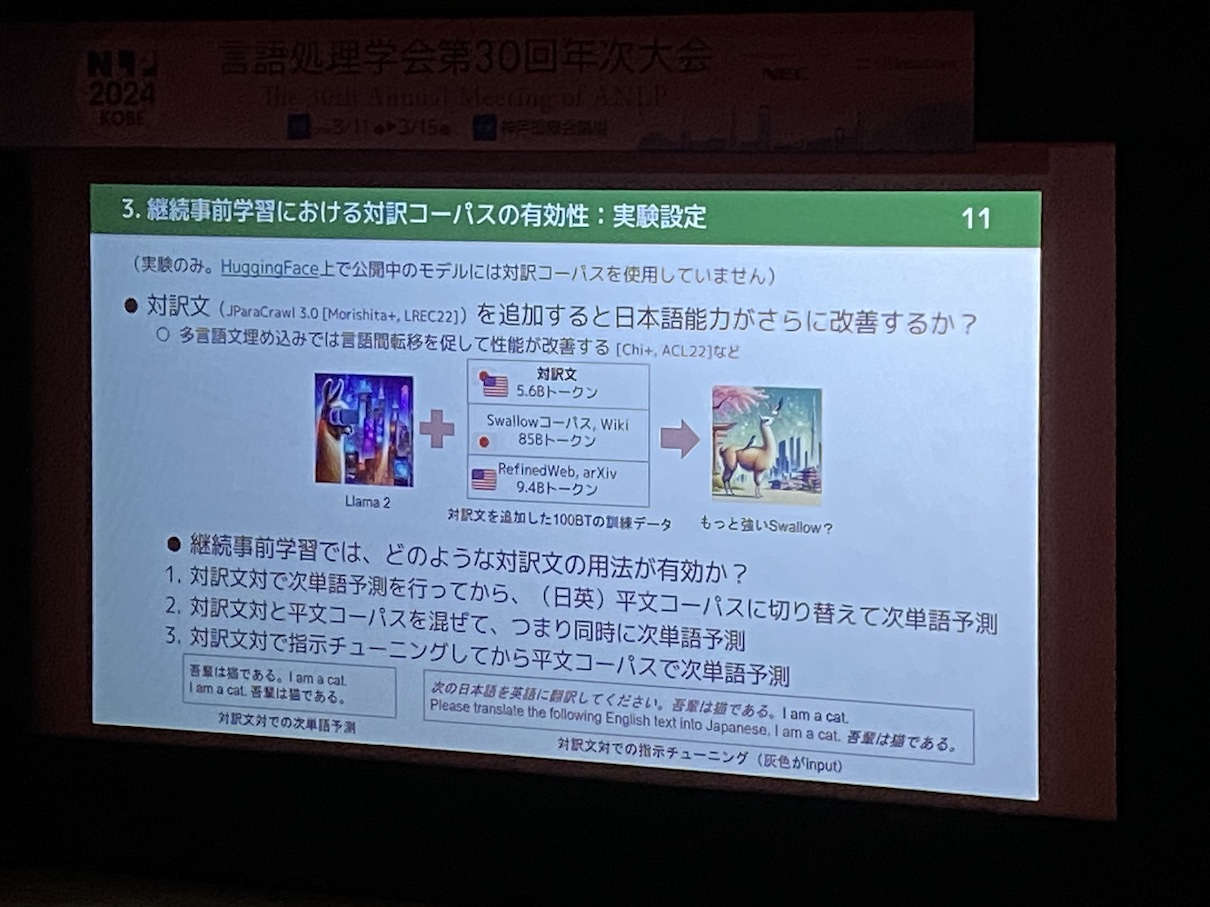

- A6-4 大規模言語モデルの日本語能力の効率的な強化: 継続事前学習における語彙拡張と対訳コーパスの活用 #Swallow

- 継続事前学習による日本語能力をベンチマークで評価

- 学習ステップ初期段階で性能低下が見られ、徐々に回復傾向

- 追加トークンは既存トークンのベクトルの平均で初期化してから学習

- 追加前後でほとんど性能差がない。自動要約のみ低下。読めるテキストは増えたが、QAタスクの学習曲線に顕著な違いはない。

- 対訳コーパスの導入

- 日英翻訳に高い改善効果。ただし推論・読解・要約能力への波及効果は認められない(現時点では)。

D7:心理言語学・認知モデリング

- D7-2 認知フィードバック:眼球運動・脳波による大規模言語モデルの強化学習

- RLHFで明示的なフィードバックを置き換えられないか、より良いフィードバック方法がないかという観点からの試み。「よりリッチなフィードバックをよりお手軽に」という問題意識自体が良い。

- RLHF => RLAIF (Casper+23)

- 低コストだがフィードバック元の性能を超えることはない

- 人間フィードバックを認知フィードバックに置き換えたい

- 明らかな正事例不事例を用意し、それを読んでる際の認知データ(ここでは眼球運動・脳波)を収集

- D7-3 早押しクイズにおける超次単語予測の認知モデリング

- 単語に対する確率を使って認知モデリングに応用しようという試み。

- D7-4 選択性を考慮した語彙エントレインメント尺度

- 同調度合いを「同義語の多さを加味すべきでは」という指摘。「客」を表す単語は複数ありその中の一つに合わせて用いる同調は、「ハサミ」を表す単語は恐らく一つで同じ単語を用いる同調とではその度合が違うだろうという問題意識らしい。

- MASKトークンへの尤度から「あえて選んだ度合い」を設定。

- D7-5 認知ファインチューニング:眼球運動による大規模言語モデルのファインチューニング

- BCCWJ-EyeTrackの文節単位読み時間をベースに、トークン毎の読み時間を設定。この読み時間を加えてファインチューニング。

- 社会実装例として「読み飛びやすさ」。より認知を加味したモデリングが可能に。

- D7-6 工学的性能と人間らしさの関係はトークン分割に依存する

- 今回の実験条件の範囲内ならそうなんだろうなと思わせる主張。トークン分割、人間どうやってるの〜。トークン化してない説もあるかもしれないが。

D8:テーマセッション1:人間と計算機のことばの評価(1)

- D8-2 最適輸送に基づく擬似訓練データを用いた機械翻訳の品質推定

- コサイン類似度+最適輸送でソフトラベル、ハードラベル設計しようという話。これで改善しやすいケース、劣化しやすいケースの傾向分析するとどう結果が出てくるのかな。

- D8-3 対義関係バイアス: 事前訓練済み言語モデルと人間の意味関係間の弁別能力に関する分析

- 確率分布からconfusabilityを求める。観察結果から強い対義関係バイアス(人間は低い)があるとの報告。他関係を対義関係に誤認しがち。

- D8-4 同時通訳・同時翻訳のための語順同期性評価

- 語順の動機度合いを加味して評価したい。

- サブワードトークンのアライメントから、スピアマンの順位相関係数を計算。

- D8-5 文法誤り訂正における参照なし評価尺度を用いた分析的評価法

- 参照がないことで低コストかつ包括的な評価がしやすい。が、1文1評価値のみで定性的な解析が難しい。

- 分単位の評価値を分配して使う。訂正単位評価値として利用。

- シャープレイ値に基づく分配

-

D8-6 評価の階層性に着目した雑談対話システム評価の分析

30 Years of Perplexity

翻訳、暗号解読あたりのここ数十年で起きたエポックメイキングな話題と、様々な自伝や思いを交えた講演。統計的翻訳論文の数式、数年読んでもどうしても分からない部分があって著者に聞いたら「あ、タイポだね」で笑いを取ってたけど、当時は怒髪天だったりしないのかなw