(NLP2024) 4日目

SABAR pic.twitter.com/K1yL5kBslX

— Naruaki TOMA 温泉旅行... (@naltoma) March 14, 2024

NLP2024の主プログラム(一般発表がある日)としては今日が最終日という位置づけらしく、クロージングも有りました。すっぽかしたけど、Slack眺める限りでは優秀賞やら次年度開催予定地で盛り上がってたようです。

今日も面白い発表あったのだけど、それ以上に昨日の認知モデリングな話がこびり付いたままだとか、単に疲れだとかであまり集中できず。実際に心に残るぐらい聞けたのは最初のセッションぐらいだな、、。

BabyBERTaなるモデルがあるらしい。人間の6歳児までの間に触れるテキストを時系列順に与えて学習させることで、学習効率が向上したという話らしい。これをベースとして、その出力や内部動作観察することでどのあたりが人間と似ているのか、違いはどこかといった観点から探られているらしい。

LLMと人間とは違うものだけれども、似ている部分もある。違いがあることを持って無用の長物になるわけではないので、モデルをどう使っていくかという点で極めて示唆的だ。

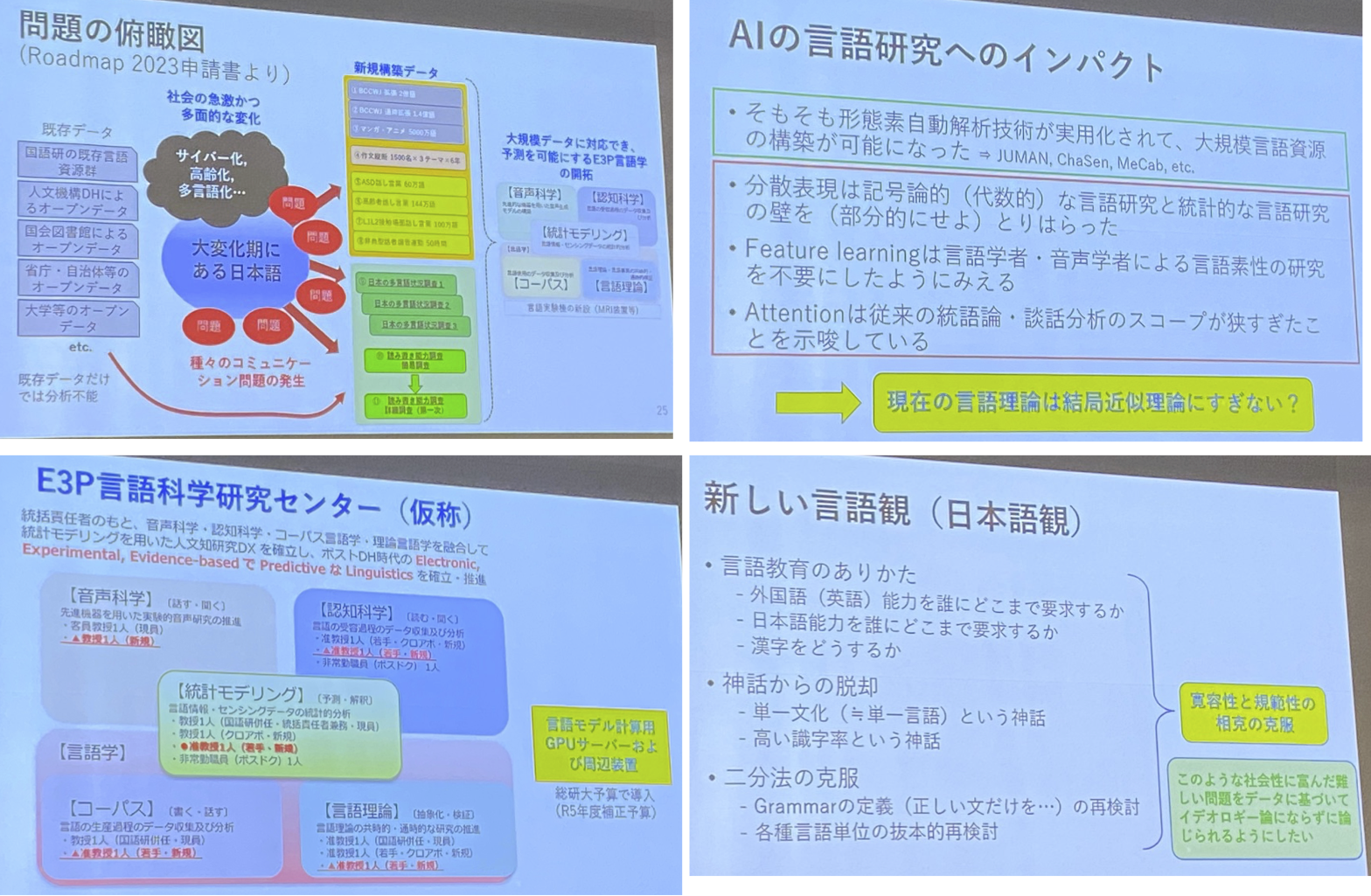

前川先生の特別講演では、国語研の生い立ちからデータで殴る話があちこちに散りばめられてたのと、「それはそれとして、過度に一般化しすぎるな」という注意喚起もあったのが良かった。シンプルな法則を求めがちだけどそれにより抜け落ちてしまう部分を無視してよいのかということを、事例交えて「これはおかしいよね」と。

ちなみに、E3P-Linguistics Centerという新センターを立ち上げるらしいです。認知科学 x モデリングな観点で取り組む模様。

E9:テーマセッション6:深層学習時代の言語学と自然言語処理(2)

- E9-1 小規模言語モデルによる子供の過剰一般化のモデリング

- BabyBERTA (Huebner '21): 6才児がそれまでに触れるテキストを時系列順にモデルに与えることで、学習効率向上

- R&M '86やそれを踏まえた研究は「単語の原型=>単語変換」するNNでの観察。そうではなく言語モデルを使いたい。

- E9-2 意味変化分析に向けた単語埋め込みの時系列パターン分析

- 通時的な意味変化を捉えたい

- E9-4 逆強化学習による文章における人間らしさの推定

- 報酬関数に対する最適方策を学習する強化学習に対し、最適方策を取るエージェントから最適方策や報酬関数を推定するのが逆強化学習。

- 言語生成過程をMDPでモデル化し、IRLで報酬推定することで「文章の個性を推定する」というタスクとみなすという話らしい。

- E9-5 Annotation of modal expressions in Indonesian

- 言語学の立場から語幹形の強さ、種類、法(mood)の関与、-nya形の記述について明らかにしたいという話。コーパス作るのも大変そうだ。。

E10:テーマセッション6:深層学習時代の言語学と自然言語処理(3)

- E10-1 大規模言語モデルの文処理は人間らしいのか?

- 人間らしさを「次単語予測確率の振る舞いの近さ」とする。サプライザル理論。

- 大きすぎるモデルは人間らしさから離れる。GPT-2 smallぐらいが近い。差分=人間らしさの説明に役立つ?

- 会場Q: 統計モデルを用いる(LLMを個人のように扱う)こと自体は妥当なのか?

- E10-2 Tree Planted Transformer: 統語的大規模言語モデルの構築に向けて

- LLMは人間と比べて学習効率が悪い (Warstadt, 2022)

- SLM => SLLM

- 正答率評価で上回ったこと=学習効率が良いという話で良いのだろうか、、?

- E10-3 自然言語、述語項構造、グラフ(項同士を線や矢印で結んだ表現形式)の表現能力や表現効率性

- 構造の効果

- 言い回しが与える「回答行為のスムーズさ」(?)

- 物語における文脈をより詳細に体系化しようぐらいの話?(言語学側でいろいろありそう)

E11:教育応用

- E11-1 教育現場における質問の性質分析と大規模言語モデルを活用した質問回答システムの検討

- Google検索結果に基づき回答する部分も気なるけど、それ以上にどこが引用で、どこがLLMが補ったのかは明示できるようにしたほうが良さそう。

特別招待講演2:これからの日本語研究と国立国語研究所:E3P-Linguisticsをめざして

国語研の生い立ち、データとして記録、保存、共有すること、AI x 音声系での事例と「データで殴る」を実践してきた強さを噛みしめる講演でした。過去の一般的な説をデータで「妥当な仮説である部分もあるが、より細かくは違う部分もある」と見せてくるのは圧巻。

同時に「過度に一般化しすぎるな」と、事例も示しながら注意喚起もあったのも良い。

認知科学 x モデリングな観点から新センター立ち上げるらしい。