読みっぱなしが気になる輪読ゼミ

複雑研全体ゼミは深層学習の5章「自己符号化」なお話。担当範囲を1週で終えられないなら複数週に跨がって良いし、単体で分かり難いなら適宜他の文献も参考にして良いよ(ピックアップ分もある)とか伝えてはあるんですが、どうにもその週を過ぎれば良しと考えてる節も少し。質疑では割と自分なりの解釈を丁寧に話してくれるので、完全ではなくてもそれなりに理解しようと頑張ったのは分かるのだけど、それを発表を通して伝える技術が足りてないという側面もあるか。ということで「次回はもっと相手に伝えるような努力が見れる発表を〜」と伝えるぐらいに。一つずつ丁寧に読んでいって欲しいとも思うのだけど。

自己符号化の章構成は次の通り。

5 自己符号化

5.1 概要

5.2 ネットワークの設計

5.2.1 出力層の活性化関数と誤差関数

5.2.2 重みの共有

5.3 自己符号化器の動き

5.3.1 データを表す特徴の学習

5.3.2 主成分分析との関係

5.4 スパース正則化

5.4.1 データの過完備な表現

5.4.2 最適化

5.4.3 スパース正則化の効果

5.5 データの白色化

5.6 ディープネットの事前学習

5.7 その他の自己符号化器

5.7.1 多層自己符号化器

5.7.2 デノイジング自己符号化器

ここでスパース正則化と白色化の話も出てくるのね。データ工学寄りの話を盛り込んだ章といったところかしら。

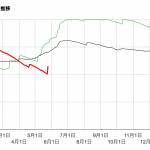

昨日の土砂降りで貯水率が結構な改善を。一度にまとまりすぎるとデメリットも強いのでもう少しなんとかなって欲しいものだが、自然のことだしなー。